Politiques “end-to-end” en IA & LLM : définitions, enjeux et bonnes pratiques. Avec l’essor des intelligences artificielles, et en particulier des grands modèles de langage (Large Language Models, LLMs), les entreprises et les institutions se trouvent face à des défis nouveaux : ne pas seulement construire des modèles performants, mais veiller à ce que leur usage soit sûr, éthique, conforme, transparent, etc.

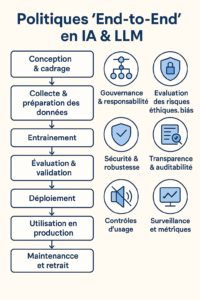

Les policies end-to-end (politiques de bout en bout) désignent l’ensemble des règles, procédures, contrôles et responsabilités qui s’appliquent sur l’ensemble du cycle de vie d’un système d’IA (et spécialement d’un LLM) : de la collecte des données à la conception, au déploiement, à l’évolution.

Qu’est-ce qu’on entend par “bout-en-bout” / “end-to-end”

“End-to-end” signifie que l’on considère toutes les phases du développement et de l’exploitation du modèle :

| Phase | Exemples d’activités |

|---|---|

| Conception et cadrage | Choix du cas d’usage, définition des objectifs, identification des risques |

| Collecte & préparation des données | Sources de données, qualité, biais, consentement, protection des données |

| Entraînement / fine-tuning | Méthodes, algorithmes, validation, robustesse |

| Évaluation & validation | Métriques de performance, tests de biais, sécurité, transparence |

| Déploiement | Infrastructure, API, contrôle d’accès, scalabilité |

| Utilisation en production | Supervision, surveillance, retour utilisateur, audits |

| Maintenance, mise à jour, retrait | Correction, patch, ajustements, suppression ou remplacement du modèle |

Dans chaque phase, des politiques doivent être définies et appliquées pour garantir que le système ne dévie pas des normes éthiques, légales, de sécurité, etc.

Pourquoi c’est crucial pour les LLMs

Les LLMs posent des défis spécifiques : Ils sont souvent entraînés sur de très grands corpus hétérogènes, ce qui peut introduire des biais implicites ou des données sensibles non intentionnelles. Leur puissance et flexibilité rendent les usages imprévisibles : ils peuvent délivrer des résultats hallucinés, inappropriés, ou même dangereux selon le contexte d’utilisation.

Les réglementations autour de la protection des données, confidentialité, droits d’auteur, lutte contre les discriminations, etc., sont de plus en plus strictes. Les attentes sociétales envers la transparence, la responsabilité (“accountability”) et l’explicabilité des modèles montent en flèche. Par exemple, la notion de Responsible AI insiste sur une stratégie end-to-end : intégrer la gouvernance, la gestion des risques, les contrôles, et la conformité dès la conception du système, pas seulement lors du déploiement.

Que couvre une policy “end-to-end” typique pour un LLM

Voici les grands thèmes qui doivent apparaître ou être pris en compte dans une politique end-to-end pour LLM :

- Gouvernance & responsabilité

- Quels rôles (éthique, légal, technique, produit) sont responsables à chaque étape

- Processus d’approbation des cas d’usage

- Protection des données & conformité juridique

- Conformité aux lois comme le RGPD, la protection des données personnelles

- Consentement, anonymisation, stockage sécurisé des données

- Évaluation des risques éthiques et biais

- Tests de biais, d’équité, de diversité dans les données et les réponses générées

- Révision humaine (“human in the loop”) pour les sorties sensibles ou critiques

- Sécurité & robustesse

- Défense contre les attaques (ex. injection de prompt, manipulation, etc.)

- Surveillance en continu, mise à jour des vulnérabilités

- Transparence & auditabilité

- Documentation des modèles, journaux (“logs”) des prompts, des versions, des décisions prises

- Possibilité d’audit interne et externe

- Contrôles d’usage & acceptable use policies

- Qu’est-ce qui est autorisé ou interdit dans l’usage du modèle (par exemple usages discriminatoires, illégaux, etc.)

- Politiques d’usage acceptable des clients ou utilisateurs

- Cycle de vie complet

- Plan de mise à jour, de réentraînement, de retrait

- Vérification que les modifications ne compromettent pas les garanties initiales

- Surveillance et métriques

- Définir des indicateurs de performance, de biais, d’effets secondaires

- Monitoring continu, retours d’usage, corrections

Exemples concrets et cas pratiques

Azure AI Gateway : Microsoft propose des “LLM policies” dans son AI Gateway, permettant de définir des limites de tokens, du monitoring, des politiques de sécurité de contenu, etc., appliquées aux modèles LLM qu’on utilise. Une entreprise peut avoir une LLM policy interne qui exige que tout usage de génération de texte à partir d’un modèle soit relu par un humain si le résultat est destiné à une communication publique. Politique “acceptable use” dans les modèles fondateurs (foundation models) — par exemple, interdiction explicite d’usage pour désinformation, discours de haine, etc.

Défis et risques de mise en œuvre

Même si les politiques end-to-end sont essentielles, leur mise en œuvre rencontre des obstacles :

- Définir ce qui est “acceptable” peut être flou : les contextes, cultures, législations diffèrent.

- Les utilisateurs finaux peuvent contourner ou ignorer des politiques s’ils ne sont pas bien formés ou motivés.

- Coût opérationnel : surveiller, auditer, documenter, mettre à jour demande des ressources.

- Évolution rapide de la technologie => les politiques deviennent vite obsolètes si elles ne sont pas révisées.

- Transparence vs sécurité/confidentialité : trop de détails peuvent exposer à des risques, mais trop peu réduit la confiance.

Bonnes pratiques pour mettre en place une policy end-to-end

Pour qu’une telle politique soit efficace, voici quelques recommandations :

- Démarrer tôt : intégrer les réflexions éthiques et de conformité dès la phase de conception.

- Impliquer toutes les parties prenantes : équipe technique, juridique, produit, conformité, utilisateurs.

- Documenter toutes les étapes : dataset, version de modèle, prompt, hyperparamètres, évaluations.

- Mettre en place des contrôles automatiques mais aussi une revue humaine : les deux sont complémentaires.

- Être agile : avoir une politique vivante, capable d’évoluer avec les retours d’expérience, les incidents, les nouveaux règlements.

- Former les utilisateurs / intervenants : pour que chacun sache ce qui est attendu (sécurité, éthique, confidentialité).

Conclusion

Les policies end-to-end dans l’IA & les LLM ne sont pas une simple “case à cocher”. Elles constituent la colonne vertébrale d’une IA responsable, fiable, conforme et digne de confiance. En couvrant toutes les phases du cycle de vie, elles permettent de minimiser les risques (juridiques, éthiques, réputationnels), tout en permettant l’innovation.

En tant qu’organisation, adopter ce type de politique est un investissement : en temps, en ressources, en gouvernance. Mais c’est un investissement nécessaire si l’on veut que les technologies d’IA soient bénéfiques, durables, et acceptables aux yeux des utilisateurs, des régulateurs, et de la société.